作者:忻怡、周楼、谦言、临在

近日,阿里云机器学习平台团队PAI通过自研的PAI-EasyCV框架复现YOLOX算法,并结合了PAI自研的PAI-Blade推理加速框架优化模型性能,使得加速过后的YOLOX-PAI在速度和精度上都比现阶段的轻量级目标检测的SOTA算法YOLOV6 提速约20%,同时,PAI-EasyCV提供高效简洁的模型部署和端到端推理接口,供社区快速体验使用YOLOX-PAI的功能。

目前,EasyCV和Blade项目已在GitHub上开源:

https://github.com/alibaba/EasyCV

https://github.com/alibaba/BladeDISC

实现方案:

1.提供了一套Apache License 训练/优化/推理的代码库以及镜像,可以实现当前社区40+mAP 量级最快(相比YOLOV6 mAP提升0.4/加速13~20%)的目标检测模型。

2.调研了YOLOX相关的改进技术和消融实验,总结了其中一些相对有帮助的改进,并以配置的方式提供出来。

3.对目标检测的端到端推理进行灵活封装及速度优化,在V100上的端到端推理为3.9ms,相对原版YOLOX的9.8ms,加速250%,供用户快速完成目标检测推理任务。

本文,我们将重点介绍如何基于PAI-EasyCV使用PAI-Blade优化模型推理过程,及如何使用PAI-EasyCV进行模型训练、验证、部署和端到端推理。欢迎大家关注和使用PAI-EasyCV和PAI-Blade,进行简单高效的视觉算法开发及部署任务。

YOLOX-PAI 精益求精的算法改进

YOLOX-PAI是阿里云机器学习平台PAI 的开源计算机视觉代码库EasyCV中集成的YOLOX 算法。通过对YOLOX 算法的分析,结合检测技术的调研,从以下4个方向对原版的YOLOX进行优化,

1.Backbone : repvgg[1] backbone

2.Neck : gsconv [2] / asff [3]

3.Head : toods[4] / rtoods

4.Loss : siou [5] / giou

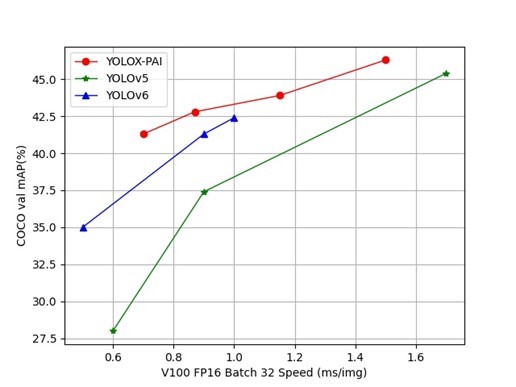

在算法改进的基础上,利用PAI-Blade对改进后的的模型进行推理优化,开发了如下的PAI-YOLOX模型。具体改进的消融实验可以参考我们的[arxiv],筛选有效改进与现有主流算法的对比结果如下:

(-ASFF 代表使用了NeckASFF, -TOODN代表使用N个中间层的TOODHead取代原有的YOLOXHead)

从结果中可以看到,相比目前同水平(1ms以内)SOTA的YOLOV6模型,融合上述改进的YOLOX-PAI在同等精度/速度的条件下有一定的速度/精度优势。(PS:上表精度测量和速度测量上与YOLOV6对齐,不包含NMS和后处理,测试精度也分图片大小等于672/640两种。)

YOLOX-PAI 简单的端到端预测

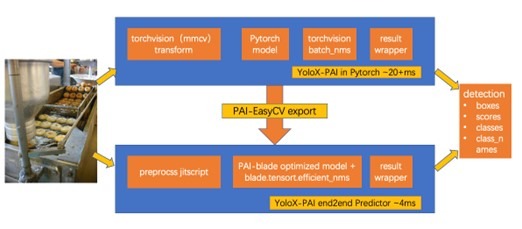

针对使用PAI-EasyCV训练的YoloX-PAI 模型,用户可以使用PAI-EasyCV自带的导出功能得到优化后的模型,并使用EasyCV 提供的TorchYoloXPredictor 进行端到端的推理。 该导出功能对检测模型进行了如下优化:

l使用PAI-Blade优化模型推理速度,简化对模型的推理加速(TensorRT/编译优化)开发流程。

l支持EasyCV配置TorchScript/PAI-Blade对图像前处理、模型推理、图像后处理分别优化,供用户灵活使用。

l支持python环境下的Predictor结构端到端的模型推理优化,简化图片预测过程。

也可以参考[EasyCV detector.py]自行组织相应的图像前处理/后处理过程,或直接使用我们导出好的模型和接口,这里提供一个已经导出好的检测模型,用户下载三个模型文件到本地[preprocess, model, meta]

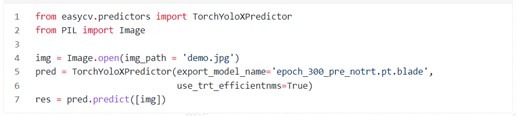

用户可以直接使用PAI-EasyCV提供的Predictor接口,通过如下简单的API调用,高效的进行图像的检测任务:

YOLOX-PAI 极致性能的推理优化

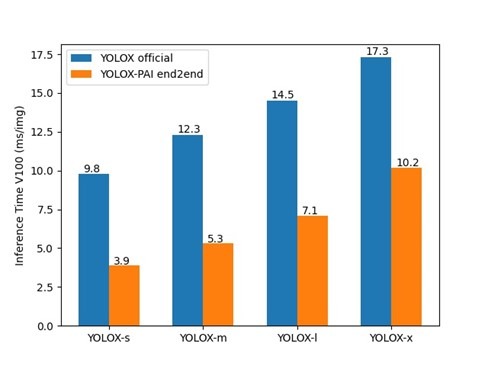

下图,我们展示了YOLOX-PAI在集成PAI-Blade/torchscript优化后和原版YOLOX的不同尺寸(s/m/l/x)模型的推理耗时对比, 在开启预处理优化和模型的PAI-Blade优化后:

可以看到PAI-EasyCV导出的模型,极大程度的优化了原模型的端到端推理速度,达到了接近250%。

PAI-Blade 推理优化

PAI-Blade是由阿里云机器学习平台PAI开发的深度学习模型优化工具,可以针对不同的设备不同模型进行推理加速优化。PAI-Blade遵循易用性,鲁棒性和高性能为原则,将模型的部署优化进行高度封装,设计了统一简单的API,在完成Blade环境安装后,用户可以在不了解ONNX、TensorRT、编译优化等技术细节的条件下,通过简单的代码调用方便的实现对模型的高性能部署。更多PAI-Blade相关技术介绍可以参考 [PAI-Blade介绍]。

PAI-EasyCV中对PAI-Blade进行了支持,用户可以通过PAI-EasyCV的训练config 中配置相关的导出(export)参数,调用PAI-Blade用于优化导出模型,结合EasyCV Predictor完成图片的端到端的图像检测任务。

写在最后

YOLOX-PAI 是PAI-EasyCV团队基于旷视YOLOX 复现并优化的在V100BS32的1000fps量级下的SOTA检测模型。整体工作上集成和对比了很多社区已有的工作:替换基于RepVGG的高性能Backbone, 在Neck中添加基于特征图融合的ASFF/GSConv增强,在检测头中加入了任务相关的注意力机制TOOD结构。结合PAI-Blade编译优化技术,同等精度下比YOLOV6 加速13~20%。EasyCV提供配套了一系列算法/训练/推理优化代码和环境,目前,YOLOX-PAI已广泛的应用在阿里集团内外的互联网,智能零售,自动驾驶等客户场景中。

PAI-EasyCV(https://github.com/alibaba/EasyCV)是阿里云机器学习平台PAI研发的计算机视觉算法框架,已在集团内外多个业务场景取得相关业务落地成果,未来将聚焦在自监督学习/VisionTransformer等前沿视觉领域,并结合PAI-Blade等自研技术不断优化。欢迎大家参与进来一同进步。

相关文献

[1] Ge Z, Liu S, Wang F, et al. Yolox: Exceeding yolo series in 2021[J]. arXiv preprint arXiv:2107.08430, 2021.

[2] YOLOv6, https://github.com/meituan/YOLOv6.

[3] Xu S, Wang X, Lv W, et al. PP-YOLOE: An evolved version of YOLO[J]. arXiv preprint arXiv:2203.16250, 2022.

[4] Wang C Y, Liao H Y M, Wu Y H, et al. CSPNet: A new backbone that can enhance learning capability of CNN[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition workshops. 2020: 390-391.

[5] Ding X, Zhang X, Ma N, et al. Repvgg: Making vgg-style convnets great again[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2021: 13733-13742.

[6] Liu S, Huang D, Wang Y. Learning spatial fusion for single-shot object detection[J]. arXiv preprint arXiv:1911.09516, 2019.

[7] YOLOv5, https://github.com/ultralytics/yolov5.

[8] Li H, Li J, Wei H, et al. Slim-neck by GSConv: A better design paradigm of detector architectures for autonomous vehicles[J]. arXiv preprint arXiv:2206.02424, 2022.

[9] Feng C, Zhong Y, Gao Y, et al. Tood: Task-aligned one-stage object detection[C]//2021 IEEE/CVF International Conference on Computer Vision (ICCV). IEEE Computer Society, 2021: 3490-3499.

[10] Gevorgyan Z. SIoU Loss: More Powerful Learning for Bounding Box Regression[J]. arXiv preprint arXiv:2205.12740, 2022.

[11] Rezatofighi H, Tsoi N, Gwak J Y, et al. Generalized intersection over union: A metric and a loss for bounding box regression[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2019: 658-666.

|